Um einen Livestream zu den Zusehern zu bekommen, braucht es mehr als ein simples Abspielgerät. In diesem Beitrag wollen wir näher auf technische Grundlagen, wie Verarbeitungsprozesse und Hardware, die für einen Livestream benötigt werden, eingehen. Wenn wir den Begriff „Livestream“ verwenden, gehen wir, sofern nicht anders definiert, in unseren Beiträgen von einem Video-Livestream aus.

Inhaltsverzeichnis

Begriffsdefinition Video-Livestream

“to broadcast video and sound of an event over the internet as it happens”

Cambridge Dictionary, n.d.

Entgegen dem Sharing, bei dem Mediendateien zum Downloaden und Speichern bereitgestellt werden, handelt es sich beim Streaming um eine temporäre Nutzung – z. B. ein Film während der Betrachtung. Die Daten werden auf dem eigenen Gerät heruntergeladen und können bereits während dem Download gesehen, gehört und genutzt werden, ohne dass dabei die Absicht einer dauerhaften Speicherung besteht. Neben dem Videostreaming hat sich diese Wiedergabemöglichkeit vor allem am Musikmarkt etabliert, was anhand der wachsenden Nutzerzahlen von Spotify und Co erkennbar ist. (Knoll, 2016, p. 133)

(Video-)Livestreaming, ist die simultane Live-Übertragung von Kamerabildern z. B. einer Veranstaltung über das Internet. Damit Zuseher und Zuseherinnen den Videostream verfolgen können, muss das Videosignal in ein für das Internet geeignetes Format transkodiert werden. Dies geschieht entweder direkt vor Ort oder in einem Rechenzentrum. Aufgrund von Enkodierung und Dekodierung entsteht ein zeitlicher Versatz, genannt Latenz, bei dem Betrachter oder der Betrachterin. (Ostermayer, 2017, p. 702)

Eine Unterscheidung zu regulärem Fernsehen lässt sich durch die Art der Übertragung definieren. Während Fernsehübertragungen an die Allgemeinheit, ohne spezifischen Empfänger, ausgestrahlt werden, ist beim Livestream eine direkte Verbindung zwischen den Endgeräten der Zuseher und Zuseherinnen sowie dem Medienserver aufgebaut. Somit bestimmt die nutzende Person aktiv, welchen Inhalt sie empfangen will. (Knoll, 2016, p. 133)

Livestreaming-Technologien

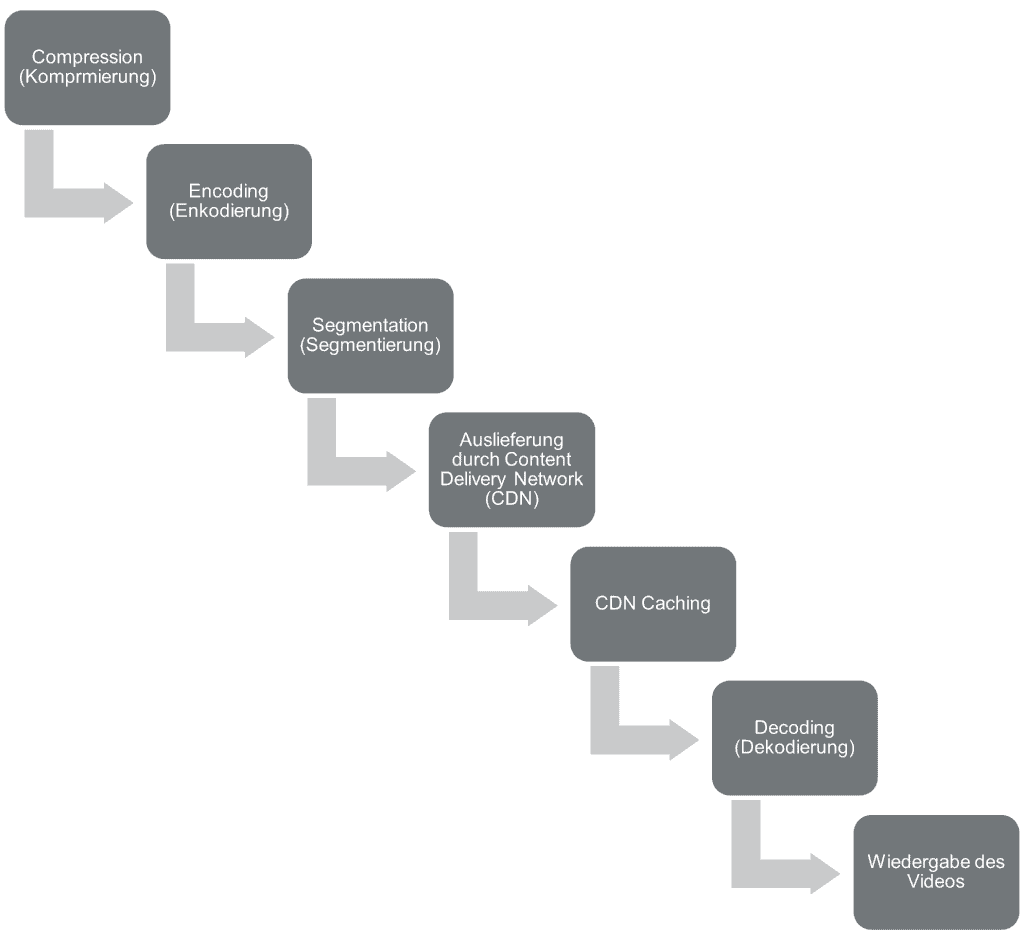

Damit der Livestream aus einem bestimmten Ort von den Zusehern und Zuseherinnen konsumiert werden kann, sind mehrere technologische Verfahren und Komponenten von Nöten. Die Schritte, die im Hintergrund geschehen, werden folgend dargestellt:

Technischer Ablauf

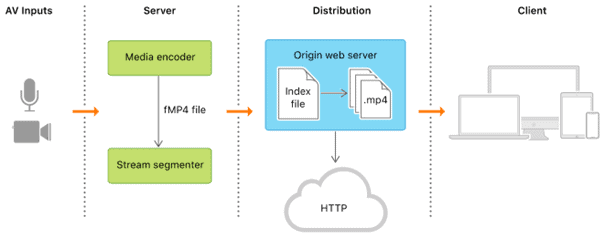

Das Livestreaming beginnt mit der Aufnahme von visuellen Informationen durch Kameras. Die rohen Videodaten werden an den Encoder gesendet, um diese in ein streamingfähiges Format zu wandeln. Die enkodierten Daten werden mittels RTMP-Protokolls an eine Streaming-Plattform oder direkt an ein Content Delivery Network (CDN) gesendet. Via CDN wird der Videostream an Zuseher und Zuseherinnen ausgeliefert. In den meisten Fällen geschieht dies über das HLS-Protokoll an einen sog. HTML5-Player bei der betrachtenden Person. (Krings, 2022)

Compression, Encoding & Segmentation

Ein Video besteht aus einer Vielzahl an Einzelbildern, die durch schnelles sequenzielles Abspielen in Bewegung gebracht werden. Nachdem Audio- und Video-Inputs digitalisiert wurden, müssen diese komprimiert und enkodiert werden, da die rohen Daten für eine schnelle Übertragung über das Internet zu groß wären. Spezielle Enkodierer, welche Hardware- oder Softwarebasiert sein können, übernehmen diese Aufgabe. (Krings, 2022)

Beim Komprimieren werden redundante Bilder und Bildinformationen entfernt. Bleiben Teile eines Einzelbildes im nächsten Bild gleich, muss diese Information nicht beibehalten werden. Encoding beschreibt den Prozess, in dem die ursprünglichen Videodaten in ein für eine Abspielsoftware interpretierbares Videoformat konvertiert werden. Die gängigsten Formatstandards sind HEVC (H.256) sowie der Vorgänger AVC (H.264). Nachdem Videodateien um ein Vielfaches größer sind als Bilder oder Dokumente, wären sie nicht für eine Direktübertragung geeignet – der Up- und Download würde zu lange dauern. Daher werden sie in kleinere, einige Sekunden lange Teile segmentiert und so übertragen. (Cloudflare, n.d.)

Oft verwechselt mit dem Encoding wird das Transcoding (Transkodieren) des Livestreams. Dabei handelt es sich um einen Prozess, bei dem das hochauflösende ursprüngliche Video in mehrere Varianten mit unterschiedlicher Qualität umgerechnet wird. Dies hat den Zweck, jedem User und jeder Userin eine für seine/ihre Internetgeschwindigkeit passende Version anzubieten. Die Qualität wird durch Auflösung und Bitrate des Videos definiert. (Krings, 2022)

Auslieferung & Caching via CDN

Ein Content Delivery Network (CDN) wird im Internet für sämtliche Medienarten – Websites, Video, Bilder und Audio – eingesetzt. Dabei handelt es sich um eine spezielle Netz-Architektur aus Servern, die anstelle des Ursprungsservers dessen Inhalte an die Nutzer und Nutzerinnen ausliefern. Da die CDN-Server auf der ganzen Welt verteilt sind, profitieren User und Userinnen von kürzeren Ladezeiten, da jeweils der ihnen näheste Server verwendet wird. Auf der Gegenseite reduziert die Nutzung des CDN die Last und die benötigte Bandbreite beim Ursprungsserver, da Anfragen durch das gesamte Netzwerk bearbeitet und verteilt werden. Die einzelnen Segmente des Videostreams werden auf den CDN-Servern gecached (zwischengespeichert), wodurch ein geringerer Zeitversatz bei Zusehern und Zuseherinnen entsteht. Da das Ziel eines jeden Livestreams sein muss, möglichst viele Menschen an möglichst vielen Orten zu erreichen und dabei höchste Qualität bei minimaler Latenz (Zeitversatz) zu bieten, sollte somit ein CDN für die Bereitstellung der Inhalte verwendet werden. (Cloudflare, n.d.)

Decoding & Wiedergabe

Nachdem der Zuseher oder die Zuseherin das enkodierte Video vom Ursprungsserver oder CDN empfangen hat, muss dieses von ihren Endgeräten dekodiert und dekomprimiert werden. Eine entsprechende Medienplayer-App oder ein webbasierter Videoplayer kann anschließend die visuellen Informationen verarbeiten und wiedergeben. (Cloudflare, n.d.)

Transcoding spielt bei der Wiedergabe des Inhaltes eine große Rolle in Bezug auf die Zufriedenheit von Zusehern und Zuseherinnen. Wird lediglich eine hochqualitative Version des Livestreams angeboten, kann das aufgrund von durch die hohe Last bedingten Schwierigkeiten bei der Wiedergabe zu Frustration bei Konsumenten und Konsumentinnen führen. Moderne Übertragungstechnologien erlauben die Bereitstellung von Multi-Bitrate und Adaptive-Bitrate Streams. Bei einem Multi-Bitrate-Stream werden mehrere Qualitätsmöglichkeiten des übertragenen Videos angeboten. Dadurch wird dem User oder der Userin die Auswahl der für die eigne Internetverbindung und das eigene Endgerät passenden Qualität des Streams und somit die unterbrechungsfreie Konsumation ermöglicht. (Graham, 2022)

Adaptive-Bitrate-Streaming ist eine Algorithmus-basierte Übertragung, bei der in Abhängigkeit von der verfügbaren Internetverbindung und dem verwendeten Endgerät vollautomatisch die bestmögliche Videoqualität angezeigt wird. Diese Anpassung wird nicht nur zu Beginn des Livestreams durchgeführt. Auch während der Wiedergabe kann der Adaptive-Bitrate fähige Medienplayer auf Schwankungen der Verbindung reagieren und die Qualität entsprechend anpassen, wodurch eine Unterbrechung des Videos durch Datenverlust oder Zwischenspeicherung verhindert wird. Während diese empfängerseitige Umsetzung in der Abspielsoftware in den meisten Fällen verwendet wird, gibt es auch bereits Umsetzungen mit serverseitiger oder hybrider Bitrate-Kontrolle. (De Cicco et al., 2014)

Neben der Bitrate spielen noch weitere Faktoren eine Rolle bei der visuellen Zufriedenheit von Zusehern und Zuseherinnen. Gerade bei Livestreams mit schnelleren Bewegungen können Kompressionsartefakte im Bild die wahrgenommene Qualität erheblich beeinflussen. Auch andere Verzerrungen oder Störfrequenzen können durch Bewegungen verstärkt werden, das Bild kann diskontinuierlich und somit nicht flüssig erscheinen. Unscharfe Kanten oder Bewegungsfehler sind weitere negative Einflüsse auf das Seherlebnis. Während für Streaming von Video-On-Demand-Inhalten bereits gute Qualitätsmechanismen existieren, ist im Bereich des Livestreamings noch weitere Forschung im Bereich von Algorithmen zur Qualitätssicherung der Übertragung nötig, um eine maximale Zufriedenheit von Zusehenden sicherzustellen. (Shang et al., 2021)

Im nächsten Beitrag werden wir auf die auch in diesem Beitrag bereits angesprochenen wichtigsten Übertragungsprotokolle blicken. Welche gibt es? Wozu werden sie verwendet? Und welche sollten verwendet werden?

Apple. (n.d.). Understanding the HTTP Live Streaming Architecture | Apple Developer Documentation. Retrieved August 19, 2022

Cambridge Dictionary. (n.d.). Livestream. Retrieved August 18, 2022

Cloudflare. (n.d.). What is live streaming? | How live streaming works. Cloudflare. Retrieved August 19

De Cicco, L., Cofano, G., & Mascolo, S. (2014). A hybrid model of the Akamai adaptive streaming control system. IFAC Proceedings Volumes (IFAC-PapersOnline), 19, 3321–3326.

Graham, K. (2022, June 23). Adaptive Bitrate vs Multi-Bitrate Streaming: A Broadcasters Guide for 2021. Dacast.

Knoll, T. (2016). Digital Reality meets Live Event: Hybride Veranstaltungsformate – eine technik-soziologische Näherung. In T. Knoll (Ed.), Neue Konzepte für einprägsame Events: Partizipation statt Langeweile—Vom Teilnehmer zum Akteur (pp. 125–146). Springer Fachmedien.

Krings, E. (2022, June 22). What is Live Streaming Technology? | How Does Video Streaming Work? Dacast.

Ostermayer, K. (2017). Veranstaltungstechnik. In C. Bühnert & S. Luppold (Eds.), Praxishandbuch Kongress-, Tagungs- und Konferenzmanagement: Konzeption & Gestaltung, Werbung & PR, Organisation & Finanzierung (pp. 689–704).

Shang, Z., Ebenezer, J., Wu, Y., Wei, H., Sethuraman, S., & Bovik, A. (2021). Study of the Subjective and Objective Quality of High Motion Live Streaming Videos. IEEE Transactions on Image Processing, PP, 1–1.